Prompting Techniken sind der Schlüssel zur effektiven Nutzung künstlicher Intelligenz (KI). Wer es versteht, KI-Modelle mit gezielten Anweisungen und Hinweisen dazu zu bringen, bestimmte Aufgaben möglichst effizient zu erledigen, ist klar im Vorteil.

Wie wäre es, wenn du lernst, wie du verschiedene Prompting Techniken einsetzt und gleichzeitig die Genauigkeit sowie den Output deines KI-Tools verbesserst?

Ob du ein KI-Modell zur Lösung komplexer Probleme einsetzen oder einfach nur effizienter mit deinem digitalen Assistenten interagieren möchtest, dieser Artikel bietet dir viele praktische Tipps.

📖 Inhaltsverzeichnis

Was ist Prompting?

Im Grunde ist es eine Methode, die du anwendest, um künstliche Intelligenz (KI) dazu zu bringen, bestimmte Aufgaben für dich zu erledigen. Dazu gibst du der KI Hinweise und Anweisungen, wie sie etwas tun soll. Es gibt verschiedene Arten von Prompting, je nachdem, welche Art von Aufgabe gelöst werden soll.

Prompting kann mit einem guten Briefing verglichen werden: So wie du in einem Briefing einer Person klare Anweisungen gibst, was sie tun soll, formulierst du in einem Prompt genau, was die KI tun soll.

Ein guter Prompt gibt alle Informationen, die nötig sind, um das gewünschte Ergebnis zu erzielen. Das können bestimmte Details, ein bestimmter Tonfall oder Stil oder eine genaue Beschreibung des Endprodukts sein.

Warum braucht KI gute Prompts?

Ein guter Prompt hilft der KI, die Aufgabe besser zu verstehen und genauer auszuführen. Dabei spielt auch die Temperatur eine Rolle, die bestimmt, wie kreativ oder fokussiert die KI antwortet. Ein höherer Wert, z.B. 0,8, führt zu kreativeren Antworten, während ein niedriger Wert zu strengeren und direkteren Ergebnissen führt.

Deine Rolle beim Prompting ist es, deinem gewählten KI-System zu helfen, die von dir gestellte Aufgabe besser zu verstehen und sie effektiver auszuführen. Das tust du mit einer Prompting Technik und passenden Anweisungen.

Was ist Prompt Engineering?

Vergleichbar ist Prompt Engineering mit dem Erlernen einer Sprache, die auch die Künstliche Intelligenz beherrscht. Nur wenn du diese Sprache kennst, bekommst du genau das, was du willst. Du gibst also ganz bestimmte Anweisungen an ein System. Dieses nimmt die Dinge, die du beschreibst und eingibst, sehr wörtlich.

Beim Prompt Engineering findest du die richtigen Worte, Sätze und Fragen, um dem KI-Modell klarzumachen, was du von ihm erwartest. Damit du das gewünschte Ergebnis erhältst, musst du möglichst präzise und klar sein.

Prompt Engineering an einem Beispiel erklärt

Die Bedeutung von Prompt Engineering wird dir vielleicht mit dem folgenden Beispiel klarer: Du möchtest, dass eine KI ein Bild von einem friedlichen Waldsee bei Sonnenuntergang erstellt. Wenn du einfach schreibst: “Erstelle ein Bild von einem See”, könnte das KI-Modell ein beliebiges Bild von einem See zu jeder Tageszeit und in jedem Zustand erstellen.

Wenn du deine Anweisung ausführlicher beschreibst: “Generiere ein Bild von einem ruhigen Waldsee bei Sonnenuntergang mit leuchtenden Farben und einer friedlichen Atmosphäre”, dann hilft diese genauere Anweisung der KI ein klareres Bild davon zu entwickeln, was du als Ergebnis erwartest.

Die Rolle von Prompt Engineering ist, die Kommunikation zwischen dir und der KI zu verbessern. Prompt Engineering stellt sicher, dass die KI das liefert, was du wirklich willst.

Prompt Engineering ist nichts Besonderes

Prompt Engineering ist keine Geheimwissenschaft. In wenigen Monaten wird es ganz normal sein, KI-Systemen Befehle (Prompts) zu geben – so wie wir heute schon Suchanfragen in Suchmaschinen eingeben.

Dazu muss niemand Prompt Engineer sein. Es wird vielmehr eine alltägliche Fähigkeit sein, die jeder intuitiv beherrscht. So wie wir mit der Zeit lernen, besser zu kommunizieren, wird auch unser Verständnis und unsere Kompetenz im Umgang mit KI-Systemen und Prompts wachsen.

Je besser die KI-Modelle werden, desto einfacher, intuitiver und natürlicher wird die Kommunikation. Statt komplizierte Anweisungen geben zu müssen, wird es in Zukunft ausreichen, unsere Wünsche in einfacher Sprache zu formulieren. Prompt Engineering wird so zu einer alltäglichen Praxis, die jeder beherrschen kann.

Was beim Prompting in Zukunft wichtig(er) wird

Prompting wird für dich als Endnutzer in Zukunft immer weniger wichtig sein, da viele KI-Systeme immer mehr Kontext erhalten – ein gutes Beispiel dafür ist Copilot.

Mit den neuesten Funktionen versucht beispielsweise Microsoft, den Umgang mit seinem KI-Chat für die Nutzer noch einfacher zu machen.

Die neuen Funktionen von Copilot im Detail

Mit Auto-Complete bekommst du Vorschläge für deinen Prompt. Rewrite schreibt deinen Prompt so um, dass die KI mehr damit anfangen kann. Catch-Up bietet dir eine Auswahl personalisierter Vorschläge mit früheren und möglichen zukünftigen Prompts.

Copilot nimmt dir nicht nur viel Arbeit beim Prompten selbst ab, sondern macht auch Vorschläge, die auf deinem Verhalten und deiner Arbeitsweise basieren.

In naher Zukunft werden dank dieser Funktionen immer weniger spezifische Prompts von dir erwartet. Die Modelle werden in der Lage sein, unsere Absichten zu erkennen und entsprechend zu reagieren, ohne dass wir detaillierte Anweisungen geben müssen.

Lerne also, Prompting Techniken jetzt richtig einzusetzen, aber sei dir bewusst, dass KI-Systeme immer intuitiver werden und die Kommunikation mit ihnen immer einfacher wird.

Was sind die Elemente eines Prompts?

Der Aufbau eines Prompts kann je nach Anwendungsfall stark variieren. Egal, ob Bild, Video, Musik oder Audio, die folgenden Bausteine findest du in allen Prompts:

Anleitung

Diese beschreibt die Aufgabe, die das KI-Modell erfüllen soll. Die Länge einer Anleitung hängt von deiner Intention ab und welche Qualität dein Ergebnis haben soll. Du wünschst dir kurze und präzise Antworten? Dann reicht eine kompakte Anweisung aus.

Du stehst vor einem schwierigen Problem, das einen komplexen Denkprozess benötigt? Eine detaillierte Beschreibung wird der KI helfen, das für dich gewünschte Ergebnis zu generieren.

Payload

Das sind zusätzliche Inhalte, wie beispielsweise Text und Bild, die du der KI für die Lösung der Arbeit zur Verfügung stellst.

Ein PDF kann zusammengefasst werden, aus einem Artikel können die wichtigsten Highlights extrahiert werden, und ein Bild stellt die Grundlage für eine ähnlich ästhetisch wirkende Bilderserie dar.

Kontext

Häufig die Zuweisung einer Rolle, die das KI-Modell bei der Erstellung eines Inhalts oder bei der Lösung eines Problems einnehmen soll. Dabei kann es sich auch um weitere Details handeln, die es der Künstlichen Intelligenz erleichtern, deine Aufgabe schneller zu erledigen.

Beispiele

Eine KI liefert noch bessere Ergebnisse, wenn du ihr zusätzliche Beispiele an die Hand gibst. Denn dann erkennt das KI-Modell ein Muster, das es auf deine Aufgabe anwenden kann. Diese Beispiele müssen keine Texte oder Bilder sein. Du kannst die KI auch dazu auffordern, diese aus anderen Quellen zu extrahieren.

Anweisungen für KI-Text-Tools enthalten meistens alle genannten Elemente. Andere KI-Generatoren wie Text-zu-Bild oder Text-zu-Video benötigen nicht alle genannten Aspekte für eine aussagekräftige Beschreibung. Dafür werden unter Umständen zusätzliche Elemente benötigt, wie Angaben zur Bildauflösung, Bildstil, Bildperspektive oder Beleuchtung.

8 verschiedene Prompting Techniken im Detail

Es gibt verschiedene Methoden, mit deren Hilfe du bessere Ergebnisse erzielen kannst. Bei einigen Prompting Techniken helfen dir die Beispiele, den Ansatz der verschiedenen Methoden selbst auszuprobieren und so besser zu verstehen.

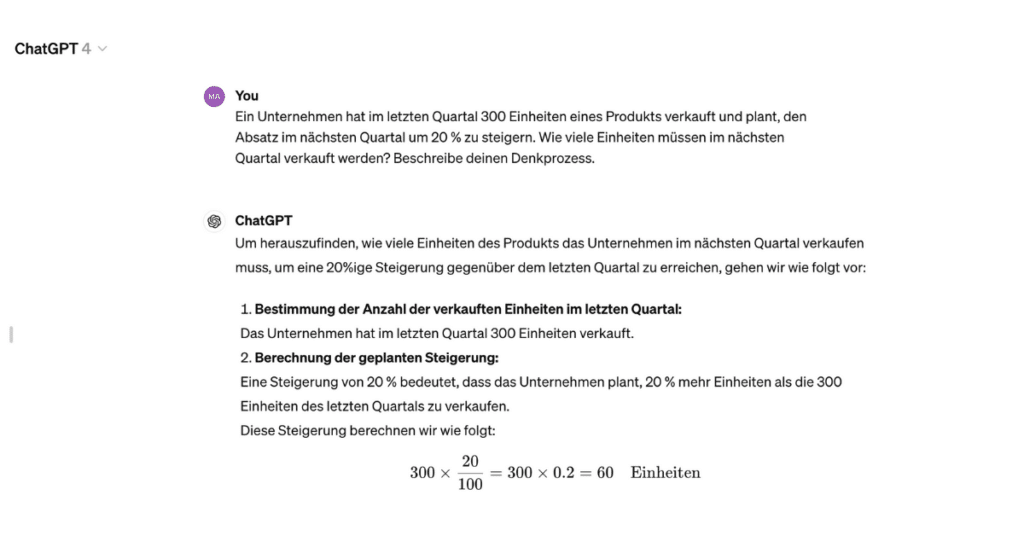

Chain-of-Thought Prompting

Diese Technik hilft Large Language Models (LLMs) komplexe Probleme zu lösen, indem du sie durch einen schrittweisen Denkprozess führst. Dabei gibst du dem Modell einige Beispiele, in denen dieser Denkprozess klar dargestellt wird. Idealerweise folgt das Modell dann diesem Denkprozess, um zur richtigen Antwort zu gelangen.

Chain-of-Thought Prompting (CoT) bringt Large Language Models dazu, ihre Vorgehensweise zu erklären, was zu genaueren Ergebnissen führen kann – insbesondere bei Aufgaben, die komplexes Denken erfordern.

Beim multimodalen CoT-Prompting kannst du sowohl Wörter als auch Bilder verwenden, um den Denkprozess des LLMs zu steuern.

Beispiel für Chain-of-Thought Prompting

Prompt: Ein Unternehmen hat im letzten Quartal 300 Einheiten eines Produkts verkauft und plant, den Absatz im nächsten Quartal um 20 % zu steigern. Wie viele Einheiten müssen im nächsten Quartal verkauft werden? Beschreibe deinen Denkprozess.

Complexity-based Prompting

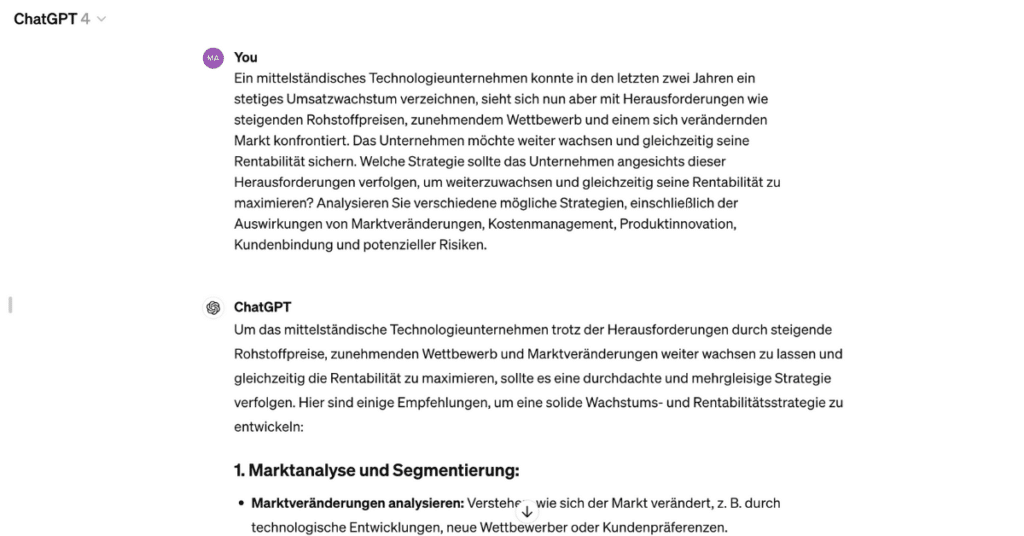

Bei dieser Methode konfrontierst du die KI mit einem komplexen, mehrstufigen Problem. Anstatt einfache Antworten zu geben, führt die Künstliche Intelligenz bei dieser Technik mehrere Prozesse durch – ähnlich wie beim Chain-of-Thought-Prompting.

Bei Complexity-based Prompting geht es allerdings nicht nur um die Verknüpfung von Gedanken, sondern um die Bearbeitung eines komplexeren Problems, das mehrere Analyseschritte erfordert.

In diesem Szenario stellst du der KI eine Frage, die nicht mit einer einfachen oder direkten Antwort beantwortet werden kann. Stattdessen muss die Künstliche Intelligenz verschiedene Aspekte betrachten, analysieren und durchdenken. Dazu kann ein Datenvergleich, das Abwägen von Vor- und Nachteilen oder das Durchspielen verschiedener Szenarien gehören.

Nach dieser Analyse wählt die KI aus den verschiedenen Ergebnissen das umfassendste oder längste aus. Das bedeutet, dass die Antwort, die am gründlichsten durchdacht und analysiert wurde und ein tieferes Verständnis des Problems zeigt, als die endgültige Antwort ausgewählt wird.

Beispiel für Complexity-based Prompting

Prompt: Ein mittelständisches Technologieunternehmen konnte in den letzten zwei Jahren ein stetiges Umsatzwachstum verzeichnen, sieht sich nun aber mit Herausforderungen wie steigenden Rohstoffpreisen, zunehmendem Wettbewerb und einem sich verändernden Markt konfrontiert.

Das Unternehmen möchte weiter wachsen und gleichzeitig seine Rentabilität sichern.

Welche Strategie sollte das Unternehmen angesichts dieser Herausforderungen verfolgen, um weiter zu wachsen und gleichzeitig seine Rentabilität zu maximieren?

Analysiere verschiedene mögliche Strategien, einschließlich der Auswirkungen von Marktveränderungen, Kostenmanagement, Produktinnovation, Kundenbindung und potenzieller Risiken.

Directional-stimulus Prompting

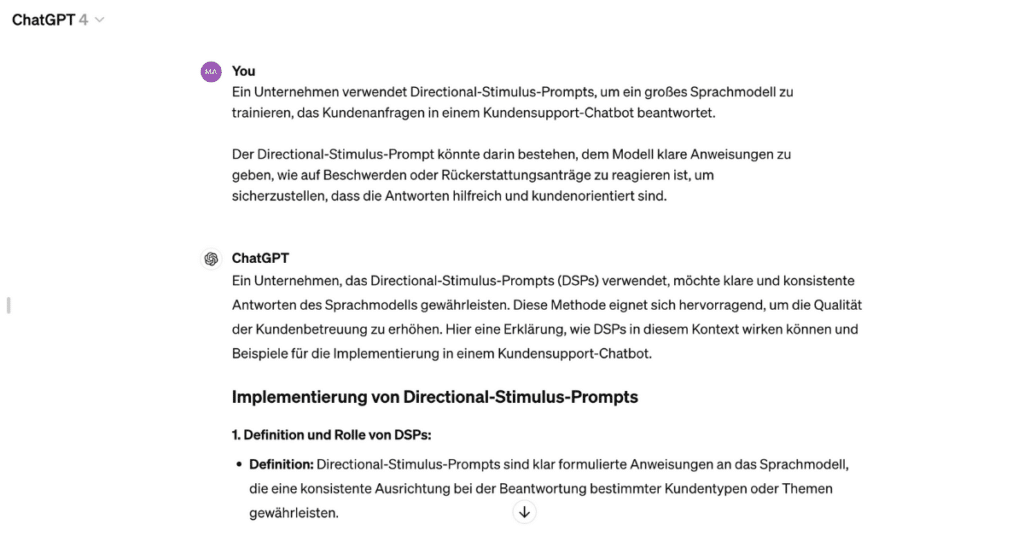

Mit diesem Konzept werden LLMs trainiert. Die Anweisungen, die du dem LLM erteilst, werden “Directional Stimulus” genannt. Diese fungieren für das Large Language Model wie Wegweiser oder Hinweise. Sie helfen dir, das LLM bei der Bearbeitung von Anfragen in die gewünschte Richtung zu lenken.

Diese Hinweise können Schlüsselwörter enthalten, die in den Antworten des Large Language Model erscheinen sollen. Ziel von Directional-stimulus Prompting ist es, die Leistung von LLMs zu verbessern, indem diesen Modellen klare und angepasste Anweisungen für ihre Antworten gegeben werden.

Beispiel für Directional-stimulus Prompting

Ein Unternehmen verwendet Directional-Stimulus-Prompts, um ein großes Sprachmodell zu trainieren, das Kundenanfragen in einem Kundensupport-Chatbot beantwortet.

Der Directional-Stimulus-Prompt könnte darin bestehen, dem Modell klare Anweisungen zu geben, wie auf Beschwerden oder Rückerstattungsanträge zu reagieren ist, um sicherzustellen, dass die Antworten hilfreich und kundenorientiert sind.

Generated Knowledge Prompting

Mach dir die Fähigkeit von KI-Modellen zunutze, um spezifische Aufgaben zu lösen und Wissen zu generieren.

Durch die Bereitstellung von Beispielen und die Anleitung der KI zu einem bestimmten Problem kann die KI Wissen generieren, das dann zur Lösung der konkreten Aufgabe verwendet werden kann.

Generated Knowledge Prompting kann mit externen Quellen wie APIs oder Datenbanken kombiniert werden, um die Problemlösungsfähigkeiten der KI weiter zu verbessern.

Beispiel für Generated Knowledge Prompting

Prompt: Entwickle einen Plan zur Verbesserung der Kundenzufriedenheit für ein E-Commerce-Unternehmen unter Berücksichtigung aktueller Trends im Online-Shopping, Kundenfeedback und Best Practices in der Branche.

Least-to-Most Prompting

Bei dieser Technik wird ein komplexes Problem in eine Reihe einfacherer Teilprobleme zerlegt. Diese werden dann Schritt für Schritt gelöst.

Least-to-Most Prompting hilft LLMs, komplexe Probleme effizienter zu lösen. Dies gilt insbesondere für Probleme, die über die Beispiele in den Trainingsdaten hinausgehen.

Beispiel für Least-to-Most Prompting

Prompt: Beginne mit der Identifizierung der grundlegendsten Herausforderungen, denen ein kleines Start-up gegenübersteht.

Erarbeitete dann schrittweise komplexere Strategien zur Skalierung des Unternehmens, einschließlich Marketing, Finanzierung und Produktentwicklung.

Maieutic Prompting

Mit dieser Methode kannst du aus unzuverlässigen Sprachmodellgenerierungen eine korrekte Antwort auf deine Frage ableiten. Maieutic Prompting arbeitet mit schlüssigem Denken, um die Genauigkeit der generierten Antworten zu erhöhen.

Du stellst mit dieser Technik sicher, ob das LLM deiner Wahl eine gegebene Antwort fortlaufend gibt und sich damit sein Verständnis – zu einem Sachverhalt – nicht ändert.

Beispiel für Maieutic Prompting

Prompt: Die geringe Kaufkraft der Bevölkerung ist schuld an der Rezession.

Self-refine Prompting

Ein iterativer Ansatz, mit dem du die anfänglichen Ausgaben eines Large Language Models durch wiederholtes Feedback verbesserst. Dabei erzeugt das LLM zunächst eine Ausgabe, erhält von dir dann Feedback und nutzt dieses, um die Ausgabe zu verbessern.

Dieser Prozess wird mehrmals wiederholt, um die Qualität des Ergebnisses schrittweise zu verbessern. Self-Refine Prompting benötigt kein zusätzliches Training oder die Eingabe von Trainingsdaten. Es verwendet stattdessen ein einziges LLM als Generator, Optimierer und Feedbackgeber.

Beispiel für Self-refine Prompting

Prompt: Entwickle einen ersten Marketingplan für ein neues Produkt. Überprüfe den Plan nach jedem Schritt, um mögliche Verbesserungen zu identifizieren, und integriere diese Erkenntnisse, um den Plan kontinuierlich zu optimieren.

Tree-of-Thought Prompting

Auch mit dieser Technik kannst du LLMs dazu bringen, komplexe Probleme zu lösen. Beim Tree-of-Thought Prompting (ToT) förderst du allerdings einen nicht linearen Prozess, der sich in verschiedene Bereiche verzweigen kann.

Dein Ziel mit ToT ist die Erstellung eines Gedankenbaums. Jeder Gedanke ist eine zusammenhängende Sequenz von Sprachäußerungen als Zwischenschritt auf dem Weg zur Lösung deines Problems.

Wenn du diese Prompting Technik einsetzt, kann das LLM verschiedene Denkwege erkunden und für dich beurteilen, welche Wege potenzielle Lösungen sind und welche nicht.

Beispiel für Tree-of-Thought Prompting

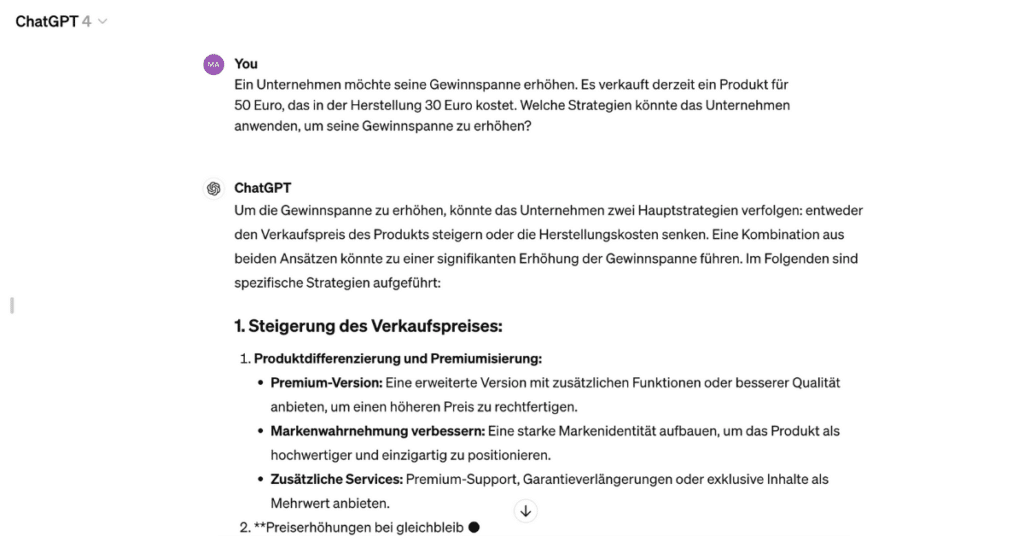

Prompt: Ein Unternehmen möchte seine Gewinnspanne erhöhen. Es verkauft derzeit ein Produkt für 50 Euro, das in der Herstellung 30 Euro kostet. Welche Strategien könnte das Unternehmen anwenden, um seine Gewinnspanne zu erhöhen?

Tipp: Weitere Prompting Techniken und Strategien findest du auch bei OpenAI.

Tipps für bessere Prompting Techniken

Mit dem KI-Modell deiner Wahl effektiv zu kommunizieren, ist gar nicht so einfach. Damit du präzise Ergebnisse erhältst, müssen deine Prompts gut durchdacht und formuliert sein. Anders formuliert: Du musst die verschiedenen Prompting Techniken richtig anwenden und genau wissen, welche Technik sich für welche Anwendung tatsächlich eignet.

Die folgenden Tipps helfen dir dabei, deine Prompts und die verschiedenen Techniken noch effektiver zu gestalten:

Halte dich kurz und präzise

Formuliere kurze und klare Anweisungen. Gib der KI genügend Informationen, damit sie genau versteht, was du willst.

Bei Texten solltest du genau beschreiben, was du erwartest und in welcher Form das KI-Modell dieses ausgeben soll. Bei Bildern sind spezifische Schlüsselwörter und Bildeigenschaften wichtig. Versuche dabei, Zweideutigkeiten zu vermeiden.

Weitere Tipps für die perfekten Midjourney Prompts findest du in diesem Beitrag.

Finde die Balance zwischen Kontext und Einfachheit

Eine gute Anweisung ist präzise, aber nicht zu kompliziert.

Verwende eine einfache Sprache. Zu lange oder komplexe Prompts können zu Missverständnissen führen, während bei zu kurzen Prompts potenziell wichtige Details fehlen.

Google Bard oder ChatGPT: Fragst du dich, welcher Textgenerator die besseren Ergebnisse erzielt? In diesem Vergleich findest du es heraus.

Setze Metaphern und Vergleiche ein

Experimentiere mit Metaphern und Vergleichen. Sie können dir dabei helfen, komplexe Ideen an den Textgenerator deiner Wahl zu vermitteln.

Probiere verschiedene Prompts aus

Probiere verschiedene Techniken und finde heraus, welche für dich die besten Ergebnisse liefern.

Für jedes KI-Modell kann sich eine andere Technik als nützlich erweisen. Ein wenig Geduld wirst du also auch benötigen, um die passende Prompting Technik zu finden.

Bist du im Marketing tätig und suchst geeignete Prompts, um diverse Aufgaben in Zusammenhang mit ChatGPT zu verbessern oder effektiver zu gestalten? Dann bietet dir der folgende Beitrag 30+ Marketing-Prompts zum Ausprobieren.

Verwende Promptgeneratoren

Zögere nicht, Bots oder Generatoren zu verwenden, um dir bei der Prompterstellung helfen zu lassen. Weise einen Bot an, Prompts für ein anderes System zu generieren, wie zum Beispiel ChatGPT, um Prompts für die Bilderzeugung zu erstellen.

Prompt Challenger GPT hilft dir dabei, bessere Prompts zu texten. Entscheide dich für einen der beiden vorgestellten Midjourney Prompt Builder, um bessere Bilder mit Midjourney zu generieren.

Bis du die richtige Formulierung und die passende Technik für dich gefunden hast, wirst du viel ausprobieren und anpassen. Das macht das Erlernen von Prompting Techniken zu einem Prozess, den du kontinuierlich optimieren kannst.

Welche Risiken sind mit Prompt Engineering verbunden?

Die Steuerung generativer KI und der dazugehörige Einsatz von Prompting Techniken bringen trotz ihres Nutzens gewisse Risiken. So kann das tiefe Verständnis der Interaktionen zwischen Menschen und KI-Systemen auch missbräuchlich eingesetzt werden. Verschaffe dir im Folgenden einen Überblick über Risiken, die bei Prompt Engineering auftreten können.

Distributional Adversarial Noise (DAN)

Durch gezielte Manipulation von Anweisungen wird versucht, das Verhalten des KI-Modells zu stören oder (negativ) zu beeinflussen. Das kann die Zuverlässigkeit und Sicherheit des jeweiligen KI-Systems gefährden.

Jailbreaking

Ein KI-Modell wird durch manipulierte Anweisungen dazu gebracht, unerwünschte oder unvorhergesehene Aktionen auszuführen. Das führt zu unerwünschten Verhaltensweisen oder sogar zu Sicherheitsproblemen, wenn eine KI eigene programmierte Grenzen überschreitet.

Prompt Injection

Wenn Prompts nicht sorgfältig entwickelt werden oder zusätzliche Informationen, die zum Prompt hinzugefügt werden, verfälscht sind, besteht die Gefahr der Voreingenommenheit oder die generierten Ergebnisse sind ungenau – oder sogar falsch. Solche Fehler führen dazu, dass das KI-Modell unbeabsichtigte Vorurteile oder unerwünschtes Verhalten verstärkt.

Prompt Leakage

Hierbei kommt es zu einer Offenlegung von Informationen oder Mustern aus den Anweisungen. Das KI-Modell lernt unerwünschte Muster oder greift auf sensible Daten zu – was insbesondere in Bereichen mit Datenschutzanforderungen problematisch ist.

Überlege bei der Verwendung von Prompt-Techniken sorgfältig, wie die Anweisungen entwickelt werden. Stelle sicher, dass dein KI-Modell zuverlässig und sicher arbeiten kann, ohne unbeabsichtigte Folgen oder Sicherheitsrisiken zu verursachen.

Die Erstellung von GPTs birgt ebenfalls Risiken im Hinblick auf Datenschutz und Datensicherheit. Mit welchen Herausforderungen du bei der Erstellung eigener GPTs rechnen musst, erfährst du in einem weiteren Beitrag.

Fazit: Lerne, Prompting Techniken richtig anzuwenden

Wenn du das Potenzial von KI ausschöpfen und sie erfolgreich in verschiedenen Anwendungsbereichen einsetzen willst, kommst du um Prompting Techniken nicht herum.

Mit etwas Übung lernst du, die oben genannten Techniken richtig einzusetzen und erhältst langfristig genauere und aussagekräftigere Ergebnisse.

Dazu solltest du verschiedene Ansätze ausprobieren und deine Favoriten kontinuierlich verbessern.

Achte bei deinen Experimenten und Versuchen auf die verschiedenen Risiken, um unerwünschte Ergebnisse oder Sicherheitsprobleme zu vermeiden.