📖 Inhaltsverzeichnis

Hast du schon von MusicGen gehört? Es ist ein KI-gesteuerter Musikgenerator von Meta, der in der Lage ist, eine Textbeschreibung in 12 Sekunden Audio umzuwandeln. In einer Welt, in der künstlerische Aktivitäten immer mehr von Künstlicher Intelligenz beeinflusst werden, ist jetzt auch die Musikbranche fest in ihrem Einflussbereich verankert. Genau wie ChatGPT und andere große, sprachbasierte KI-Modelle Texte erstellen, hat Meta nun eine Open-Source-Version ihres KI-Modells zur Generierung von Musik veröffentlicht.

Was ist MusicGen?

MusicGen basiert auf einem Transformer-Modell, genau wie die meisten der heute verwendeten Sprachmodelle. Es prognostiziert das nächste Segment eines Musikstücks auf ähnliche Weise, wie ein Sprachmodell die folgenden Buchstaben in einem Satz vorhersagt. Für das Training wurde eine beeindruckende Menge von 20.000 Stunden autorisierter Musik verwendet, einschließlich 10.000 hochwertiger Audioaufnahmen aus einem internen Datensatz sowie Musikdaten von Shutterstock und Pond5.

Ein besonderes Merkmal von MusicGen ist seine Fähigkeit, sowohl Text- als auch Musikhinweise zu verarbeiten. Dein eingegebener Text legt den grundlegenden Stil fest, dem die Musik in der Audiodatei folgt. Es ist jedoch wichtig zu wissen, dass die Melodie nicht perfekt im Ausgang reflektiert wird und nur als allgemeine Leitlinie für die Generierung dient.

MusicGen einfach ausprobieren

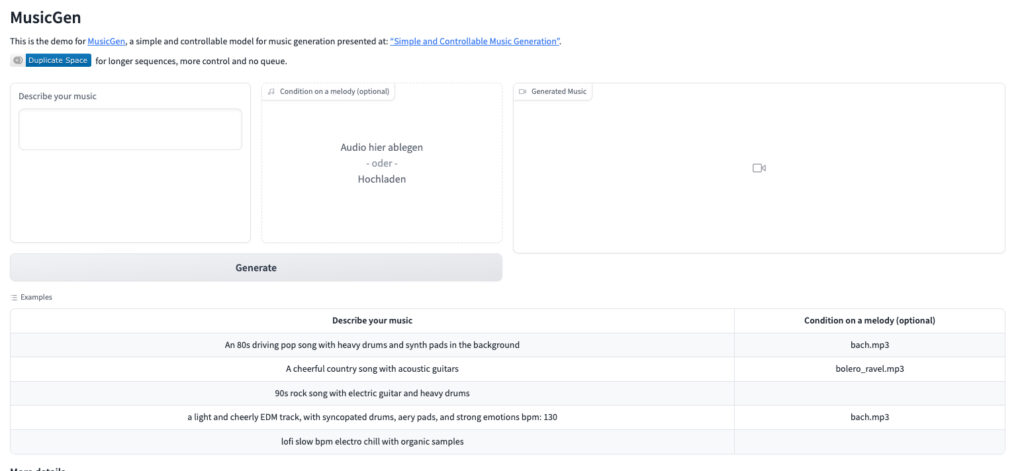

MusicGen kann über die Hugging Face API getestet werden, allerdings kann die Generierung von Musik je nach Anzahl der gleichzeitigen Nutzer etwas Zeit in Anspruch nehmen. Für schneller erzeugte Ergebnisse kannst du die Hugging Face-Website verwenden, um deine eigene Instanz des Modells einzurichten. Und wenn du die notwendigen Fähigkeiten und Geräte hast, kannst du sogar den Code herunterladen und manuell ausführen.

Deine Beschreibung wird von dem MusicGen-Modell verwendet, um 12 Sekunden Audio zu generieren. Du kannst auch eine Referenzaudiodatei bereitstellen, aus der eine komplexe Melodie erstellt wird. Durch die Verwendung der Referenzaudio wird das Modell versuchen, Musik zu erstellen, die besser den Vorlieben des Benutzers entspricht, indem es sowohl der Beschreibung als auch der bereitgestellten Melodie folgt.

Beispiele für MusicGen

Ein besonderes Merkmal von MusicGen ist seine Fähigkeit, sowohl Text- als auch Musikhinweise zu verarbeiten. Dein eingegebener Text legt den grundlegenden Stil fest, dem die Musik in der Audiodatei folgt. Es ist jedoch wichtig zu wissen, dass die Melodie nicht perfekt im Ausgang reflektiert wird und nur als allgemeine Leitlinie für die Generierung dient.

A happy pop song with acoustic guitars

A powerful EDM track bpm- 130

90s rock song with electric guitar and heavy drums

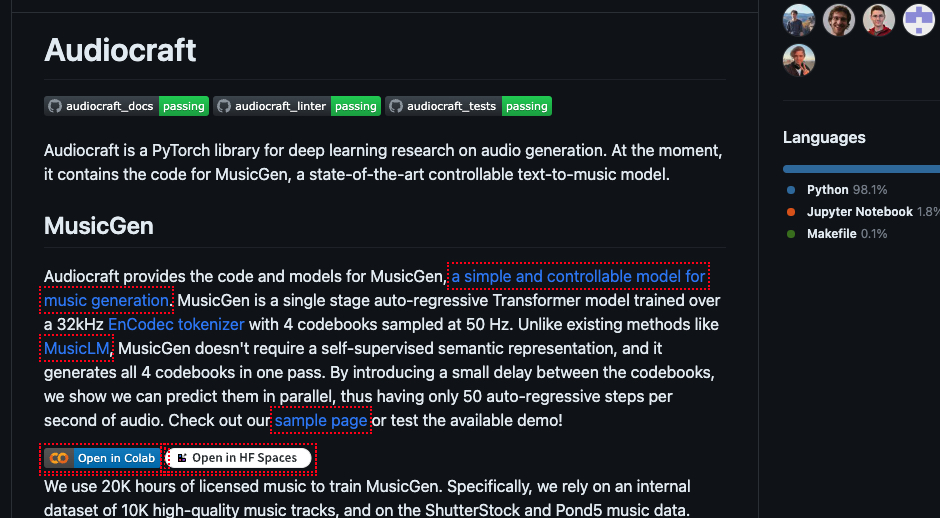

MusicGen und Audiocraft selbst installieren

Meta stellt MusicGen auf Github bereit. So kannst du das Modell bzw. verschiedene Modelle über die API auch auf eigenen Projekten nutzen und somit auch weit aus mehr als nur 12 Sekunden Musik produzieren.

Auswirkungen auf die Musikindustrie

Künstliche Intelligenz (KI), insbesondere in Form von Musikgeneratoren, hat erhebliche Auswirkungen auf die Musikindustrie. Mit diesen Technologien können Musikproduzenten neue Stücke schnell und effizient erstellen, ohne Stunden damit zu verbringen, Musik von Grund auf zu komponieren. Stattdessen können sie einfach ein paar Parameter eingeben und der KI-Musikgenerator erledigt den Rest.

Eine der Herausforderungen bei KI-generierter Musik besteht darin, dass sie Gefühle und echte Kreativität vermissen lassen kann, da sie auf vorhandenen Musikdaten basiert und nicht den menschlichen Touch hat, der für gute Musik so wichtig ist. Dennoch ist die Zukunft von KI-Musikgeneratoren in der Musikindustrie hell und voller Potenzial.

Mit der kontinuierlichen Entwicklung und Innovation haben KI-Musikgeneratoren das Potenzial, eine wichtige Rolle bei der Gestaltung der Zukunft der Musikindustrie zu spielen. Sie eröffnen Musikproduzenten neue und aufregende Möglichkeiten, Musik zu schaffen, und Hörer können ein dynamischeres und vielfältigeres Musikerlebnis genießen.

Darüber hinaus ist ein Trend zu beobachten, bei dem KI zur Verbesserung der menschlichen Kreativität eingesetzt wird, personalisierte Musik erstellt und Spannung in Live-Musikaufführungen hinzufügt. Dieser Trend wird voraussichtlich weiterhin bestehen und wachsen, während KI-Musikgeneratoren immer ausgefeilter werden.

Was ist MusicGen und wie funktioniert es?

MusicGen ist ein von Meta entwickelter, KI-basierter Musikgenerator, der Textbeschreibungen in 12 Sekunden Audio umwandeln kann. MusicGen basiert auf einem Transformer-Modell, das ähnlich wie Sprachmodelle arbeitet, indem es den nächsten Teil eines Musikstücks vorhersagt. Es nutzt den EnCodec-Audio-Tokenizer von Meta, um Audiodaten in kleinere Stücke zu zerlegen und führt die Token-Verarbeitung parallel durch. Ein Benutzer kann sowohl Text- als auch Musikhinweise geben, die das Modell dann zur Erstellung des Audio-Outputs verwendet.

Wie kann ich MusicGen nutzen?

MusicGen kann über die Hugging Face API getestet werden, allerdings kann die Generierung von Musik je nach Anzahl der Nutzer, die es gleichzeitig verwenden, etwas Zeit in Anspruch nehmen. Für schneller Ergebnisse können Sie die Hugging Face-Website verwenden, um Ihre eigene Instanz des Modells einzurichten. Falls Sie die notwendigen Fähigkeiten und Ausrüstung haben, können Sie den Code herunterladen und manuell ausführen.