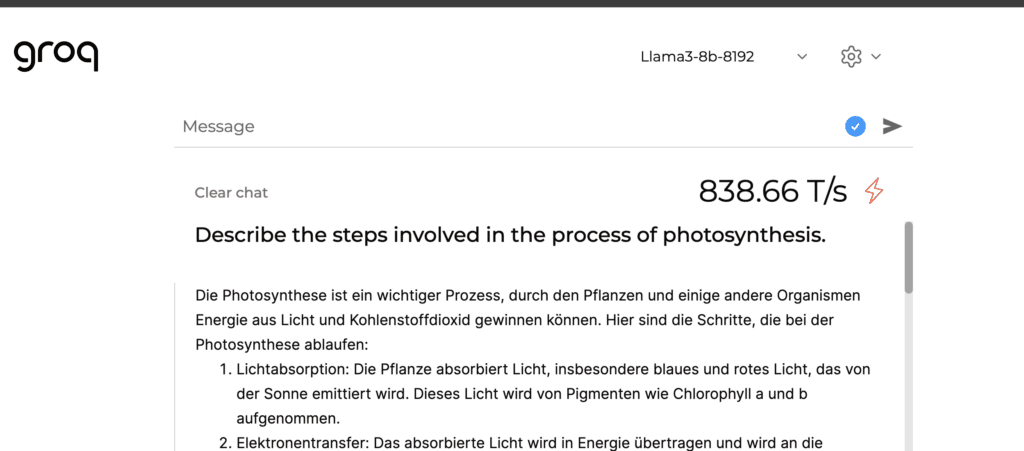

Groq, das innovative Unternehmen, das auf LPUs (Language Processing Units) anstelle von GPUs setzt, hat mit dem neuesten Llama 3 Modell von Meta einen beeindruckenden Geschwindigkeitsrekord aufgestellt. Mit der 7b Version von Llama 3 erreicht Groq über 800 Token pro Sekunde – ein Vielfaches der Geschwindigkeit von ChatGPT 3.5, das etwa 100 Token pro Sekunde verarbeitet.

Diese bahnbrechende Leistung eröffnet völlig neue Möglichkeiten für KI-Chats und die Interaktion mit künstlicher Intelligenz. Stell dir vor, du erhältst die Antworten auf deine Fragen in Sekundenschnelle, ohne spürbare Verzögerung. Genau das macht Groq mit Llama 3 möglich.

Groq setzt auf Open-Source Modelle

Interessanterweise nutzt Groq aktuell ausschließlich Open-Source Modelle für ihren KI-Chat, darunter die Llama Modelle von Meta sowie Mixtral und Gemma von Google. Obwohl diese Modelle in den meisten Aufgaben noch hinter führenden Modellen wie Claude Opus oder GPT-4 liegen, bin ich überzeugt, dass es nur eine Frage der Zeit ist, bis Open-Source Modelle das heutige GPT-4 Level erreichen.

Wenn es soweit ist, wird die Geschwindigkeit von Groq eine noch größere Rolle spielen. Denn die Kombination aus hochqualitativen Open-Source Modellen und der rasanten Verarbeitungsgeschwindigkeit von Groq könnte die KI-Landschaft nachhaltig verändern.

Die Vorteile von schnelleren KI-Chat Modellen

Aber was bringt diese beeindruckende Geschwindigkeit eigentlich? Natürlich profitieren ungeduldige Nutzer wie ich davon, die Antworten in wenigen Sekunden zu erhalten. Doch die Vorteile gehen weit darüber hinaus:

- Kombination verschiedener Modelle und Validierungen zur Qualitätsverbesserung, ohne die Antwortzeit zu beeinträchtigen

- Enormes Potenzial für die Verarbeitung von Sprache und die Interaktion mit KI-Systemen

- Möglichkeit, komplexe Aufgaben und Berechnungen in Echtzeit durchzuführen

Mit der Geschwindigkeit von Groq und Llama 3 eröffnen sich völlig neue Anwendungsszenarien für KI-Chats, die bisher aufgrund der Latenz nicht möglich waren.

Fazit: Ein Quantensprung in der KI-Chat Geschwindigkeit

Groq und Llama 3 haben bewiesen, dass die Grenzen der KI-Chat Geschwindigkeit noch lange nicht erreicht sind. Mit über 800 Token pro Sekunde setzen sie neue Maßstäbe und zeigen, wohin die Reise gehen könnte.

Auch wenn die aktuell verwendeten Open-Source Modelle noch nicht ganz mit den führenden Modellen mithalten können, bin ich überzeugt, dass sich das in naher Zukunft ändern wird. Die Kombination aus hochqualitativen Modellen und der Geschwindigkeit von Groq könnte die Art und Weise, wie wir mit KI interagieren, revolutionieren.

Wenn du selbst erleben möchtest, wie schnell KI-Chats sein können, empfehle ich dir, Groq unter https://groq.com/ selbst auszuprobieren. Ich bin gespannt auf deine Erfahrungen und Eindrücke!