Synthetische Stimmen haben in den letzten Jahren enorme Fortschritte gemacht. Anbieter wie ElevenLabs und andere Projekte zeigen bereits eindrucksvoll, was heute möglich ist. Doch oft fehlt diesen KI-generierten Stimmen noch etwas Entscheidendes: Emotionen. Genau hier setzt Hume AI mit seiner beeindruckenden Demo an.

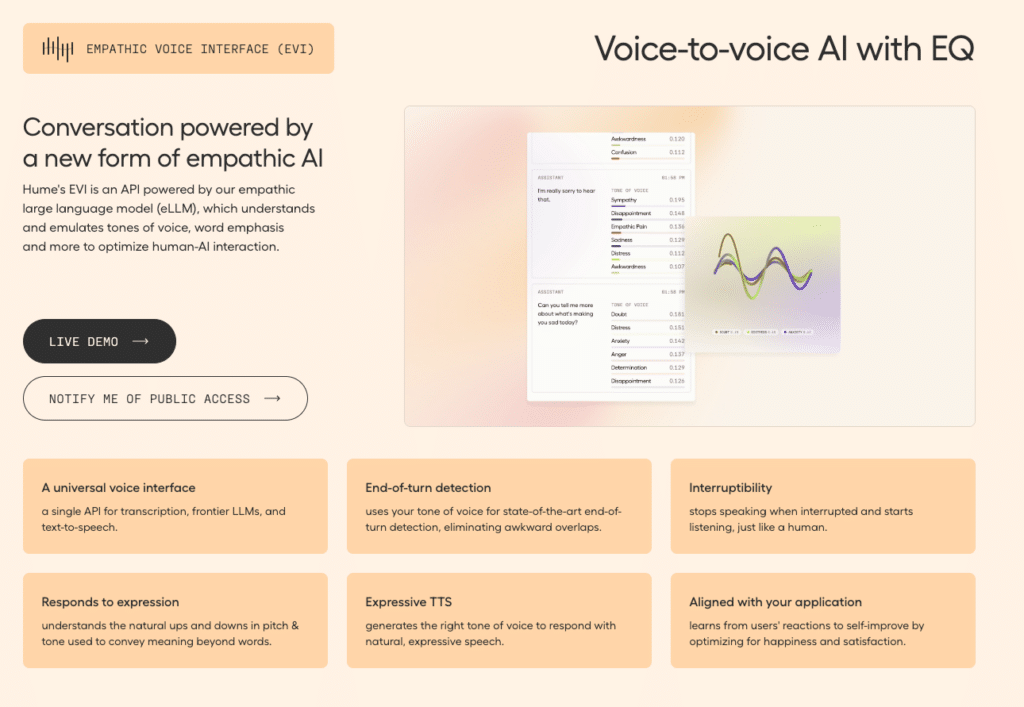

Empathic Voice Interface (EVI) – KI, die mitfühlt

Mit EVI hat Hume einen empathischen Voice-Assistenten entwickelt, der anhand der Stimmlage und der darin transportierten Emotionen mit dir kommuniziert. Ich habe es selbst ausprobiert und war erstaunt, wie die KI auf Änderungen in meiner Stimmung reagierte – egal, was auf meiner Tonspur passierte. Das Herzstück von EVI ist ein „empathisches Large Language Model“ (eLLM), das Tonfall, Betonung und mehr versteht und nachahmt, um die Mensch-KI-Interaktion zu optimieren. Es handelt sich um eine universelle Sprachschnittstelle, die Transkription, fortschrittliche LLMs und Text-to-Speech in einer einzigen API vereint. Erweiterte Funktionen wie die Erkennung des Gesprächsendes anhand des Tonfalls, Unterbrechbarkeit (stoppt, wenn unterbrochen wird und hört zu, wie ein Mensch) und die Reaktion auf die Ausdrucksweise (versteht natürliche Tonhöhen- und Tonänderungen) machen EVI zu einem außergewöhnlichen Werkzeug für die Gestaltung empathischer Benutzererfahrungen.

Emotionserkennung in Echtzeit

Das Besondere an Hume ist die Fähigkeit, Emotionen aus Text-Aussagen in Echtzeit zu erkennen. Im Video siehst du, wie jede Aussage – sowohl von mir als auch von der KI – analysiert und drei Emotionen zugeordnet wird, unabhängig vom Inhalt des Gesagten. Die Generierung der Antworten erfolgt dabei nahezu in Echtzeit. Neben der beeindruckenden Geschwindigkeit, die manche KI-Modelle bereits erreichen, kommt hier also noch der emotionale Aspekt hinzu.

Vielfältige Anwendungsmöglichkeiten

Die Integration von emotionaler Intelligenz in KI-Systeme eröffnet spannende Perspektiven für die Zukunft. Monotone und langweilige KI-Stimmen könnten schon bald der Vergangenheit angehören. Stattdessen ergeben sich interessante Anwendungsfälle im Bildungsbereich oder im Gesundheitssektor, etwa bei der Früherkennung und Überwachung emotionaler und psychischer Zustände. Auch kundenorientierte Anwendungen könnten von emotionaler Intelligenz profitieren. Durch mehr Emotionen in der Interaktion ließe sich das User-Engagement verbessern und eine stärkere Bindung zum Nutzer aufbauen. EVI lernt sogar aus den Reaktionen der Nutzer und optimiert sich selbst, um deren Zufriedenheit und Glück zu maximieren.

Fazit: Die Zukunft der Mensch-KI-Interaktion

Hume AI gibt uns mit EVI einen faszinierenden Einblick in die Zukunft der Mensch-KI-Interaktion. Die Fähigkeit von KI-Systemen, Emotionen zu erkennen und darauf zu reagieren, eröffnet völlig neue Möglichkeiten der Kommunikation und Zusammenarbeit.

Es bleibt spannend zu beobachten, wie sich emotionale KI weiterentwickeln und in unseren Alltag integrieren wird. Eines ist jedoch sicher: Die Zukunft der KI liegt nicht nur in ihrer Intelligenz, sondern auch in ihrer Fähigkeit, uns auf einer emotionalen Ebene zu verstehen und zu unterstützen.

Wie siehst du das Thema emotionale KI? Glaubst du, dass KI deine Gefühle wirklich verstehen kann?

Demo: https://demo.hume.ai/